Hoe Word Embeddings nieuwe thermo-elektriciteit ontdekken

Praat vandaag met iemand en ze zullen je vertellen dat kunstmatige intelligentie het volgende grote ding is - de hete aardappel waar iedereen een stukje van wil, maar waar niemand op kan kauwen.

Een goede meerderheid van hen zal je ook vertellen dat veel van wat als AI rondgaat, eigenlijk gewoon een hype is - een verheerlijking van de goede oude machine learning en wiskunde gekleed in Powerpoint. En voor het grootste deel zouden ze gelijk hebben.

Een gebied waar de toepassing van AI-tools zoals Deep Learning echter ronduit revolutionair is, is natuurlijke taalverwerking.

Een eenvoudig voorbeeld zijn de chatbots die websites bemannen. Ze worden beheerd door relatief gecompliceerde deep learning-architecturen, genaamd Long Short Term Memory (LSTM) neurale netwerken. Deze algoritmen kunnen 'begrijpen' wat we ze vertellen en als reactie daarop leesbare coherente zinnen samenstellen. Natuurlijk, deze bot is geen Socrates, maar hij spuugt geen willekeurige wirwar van woorden uit. Er is de onmiskenbare suggestie van intelligentie op laag niveau.

Woorden insluiten

Het moderne tijdperk van diep leren in taalverwerking begon met de publicatie in 2013 van Tomas Mikolov's word2vec-paper. Hun triomf was het ontwikkelen van een rekenkundig haalbare methode om woordinbeddingen te genereren of woordvectoren met behulp van neurale netwerken.

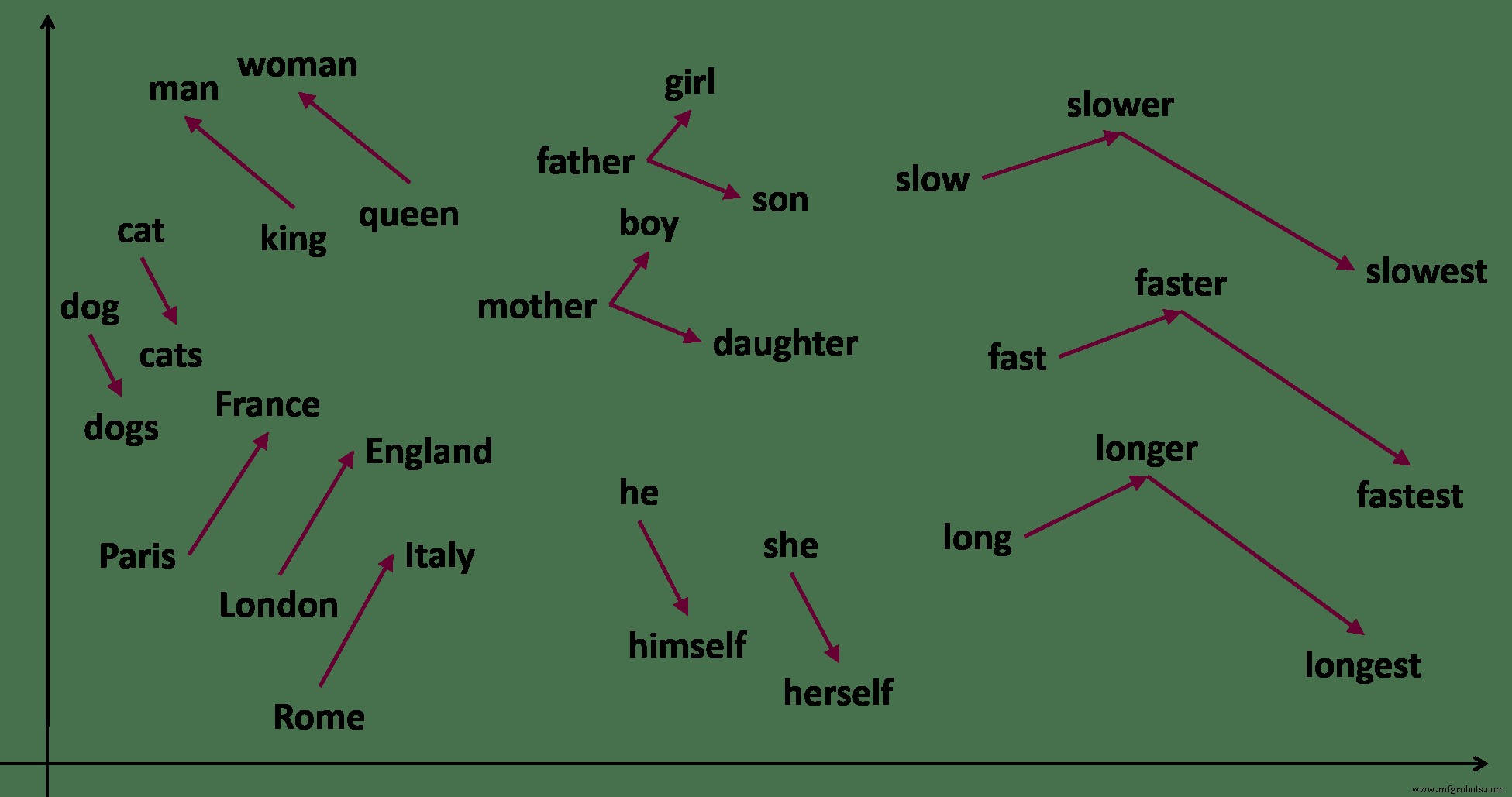

Denk aan de woorden man, vrouw, koning enkoningin . Als je werd gevraagd om deze woorden te groeperen, heb je een aantal verstandige keuzes. Ik heb de neiging om [man, vrouw . te zien ] en [koning, koningin ]. Je zou kunnen zien [man, koning ] en [vrouw, koningin ].

Woordinbedding legt semantische relaties tussen woorden in een tekst vast. Van https://samyzaf.com/ML/nlp/nlp.html

Ik weet ook dat het woord koning en man zijn op exact dezelfde manier gerelateerd als 'vrouw ’ en ‘koningin ’.

man:koning =vrouw:koningin

Zelfs als ik deze woorden nog nooit eerder had gehoord, kan ik deze relaties leren door de zinnen die ik tegenkom te observeren. 'Deze man is een koning ’ , ‘De koningin was een godvrezende vrouw ’, ‘Ze regeerde als de koningin van het witte doek ’, ‘Zijn koninkrijk zal komen ’. Deze zinnen suggereren alleen al door de nabijheid van woorden dat de koning is meestal een man en dat een koningin is hoogstwaarschijnlijk een vrouw .

Woordinsluitingen doen hetzelfde, maar dan voor miljoenen woorden uit duizenden documenten. De sleutel hier is dat de woorden worden geleerd vanuit context . Wat dit wiskundige analogiespel mogelijk maakt, zijn de krachten van moderne berekeningen en de magie van diep leren.

Deep learning woordinbedding

Laten we zeggen dat we de inbedding willen vinden voor alle woorden in Harry Potter .

We maken eerst een soort wiskundige kluis-bibliotheek-kamer. Een monsterlijke multidimensionale kolos die groot genoeg is om alle woorden te bevatten die we nodig hebben. Dit is de vectorruimte .

Het doel is om door Harry Potter . te gaan woord voor woord en leg elk woord in een kluis in de kamer. Gelijksoortige woorden als Jurk en mantel ga in dezelfde kluis. Zwerkbal en Verklikker bevinden zich in aangrenzende gewelven. Auto en Centaur zijn zo ver weg als Banaan en Voldemort .

Het woord dat een woord insluit, is het adres van de kluis waarin het zal worden gevonden. Wiskundig gezien maakt dit het een vector in de vectorruimte .

U begrijpt waarom geen mens deze baan ooit zou willen hebben. Er zijn veel te veel woorden en veel te veel beweging bij betrokken.

Een neuraal net doet dit echter uitzonderlijk goed. Het doet dit door, nou ja, magie.

A deep neural net is een soort enorme machine met miljoenen versnellingen en hefbomen. In het begin is het allemaal chaos en niets past ergens bij, ook al wordt er overal geschuifeld. Dan beginnen langzaam enkele versnellingen te vergrendelen. De hefbomen vallen op hun plaats - en orde komt voort uit chaos. De machine begint te bewegen. Frankenstein leeft!

De taal is hier bewust vaag. Ik wil je meenemen naar de toepassingen van woordinbedding, in plaats van hoe het is afgeleid. Dat gezegd hebbende, weten we op een fundamenteel niveau niet helemaal hoe neurale netwerken doen wat ze doen. Dus in onze experimenten moeten we spelen met het aantal lagen, de activeringsfuncties, het aantal neuronen in elke laag enz. voordat we aan onze taak beginnen. Maar dat is een onderwerp voor een andere dag.

Thermo-elektriciteit

In een paper dat in 2019 werd gepubliceerd, genereerde een team van onderzoekers van het Lawrence Berkeley Lab de woordinbedding van alle abstracts in ongeveer 3,3 miljoen artikelen die in 1000 tijdschriften werden gepubliceerd. Deze lijst is natuurlijk enorm en omvat bijna elk onderwerp dat de afgelopen decennia in de materiaalwetenschap is gepubliceerd.

Als het om een wetenschappelijke tekst gaat, zijn chemische formules en symbolen ook ‘woorden’. Daarom is er een woordvector voor LiCoO 2 - wat een gewone batterijkathode is. U kunt dan vragen stellen als:wat zijn de woordvectoren die het dichtst bij LiCoO2 liggen?

We weten dat LiCoO2 een vector is in de vectorruimte. We hoeven dus alleen vectoren te vinden die dichtbij zijn.

Het antwoord komt eruit als LiMn 2 O 4 , LiNi 0,5 Mn 1.5 O 4 , LiNi 0.8 Co 0,2 O 2 , LiNi 0.8 Co 0,15 Al 0,05 O 2 en LiNiO 2 -die allemaal ook lithium-ion-kathodematerialen zijn.

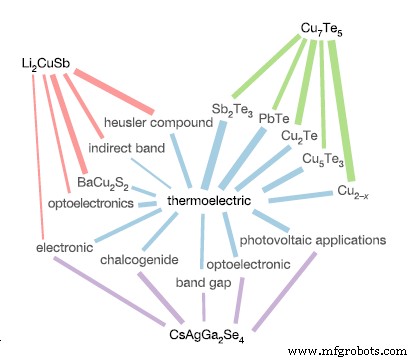

De relatieroute van geselecteerde chemische verbindingen met het woord 'thermo-elektrisch'. Li2CuSb is niet direct gerelateerd aan 'thermo-elektrisch', maar het is in de buurt van andere woorden die indicatoren zijn van deze eigenschap, zoals 'indirecte band' en 'opto-elektronica'. Van [2]

Zie je wat we hier hebben gedaan?

We probeerden echt andere materialen te verkennen die vergelijkbaar waren met onze favoriete kathode. In plaats van duizend kranten te lezen, aantekeningen te maken en een lijst met lithiumverbindingen te bedenken, loste het woord inbedding de taak in een paar seconden op.

Dit is de kracht van woordinbedding. Door semantische vragen om te zetten in wiskundige vectorbewerkingen, stelt deze benadering ons in staat om grote tekstdatabases beter en efficiënter te doorzoeken en te begrijpen.

Als ander voorbeeld bestudeerden de onderzoekers hoe vaak een chemische verbinding werd gevonden in de buurt van de vector voor 'thermo-elektriciteit ’. (Dit zijn materialen die elektrische energie omzetten in warmte of omgekeerd).

U kunt dit doen door middel van een ongecompliceerde vectorbewerking die het puntproduct wordt genoemd. Vectoren die vergelijkbaar zijn, hebben een puntproduct dat er een benadert. Ongelijke vectoren hebben een product van bijna nul punt.

Door dezelfde bewerking uit te voeren op chemische verbindingen in de database en het woord 'thermo-elektrisch ', vonden de auteurs alle chemicaliën die waarschijnlijk thermo-elektrisch waren .

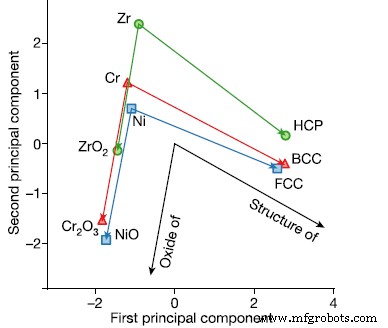

Het woord inbeddingen uit de abstracte database kan vragen beantwoorden als:Als Zr zeshoekig is, is chroom …? (Lichaam gecentreerd) Van [2]

De auteurs tonen verder aan dat vergelijkbare relaties kunnen worden aangetoond voor verschillende materiaaleigenschappen, zoals kristalstructuur en ferro-elektriciteit. Verder laten ze zien dat met behulp van deze techniek verschillende van de huidige thermo-elektriciteit jaren geleden had kunnen worden voorspeld uit bestaande literatuur.

De analyse is een zeer mooie, elegante maar bedrieglijk eenvoudige uitdrukking van de vraag 'Van alle materialen die door de mens zijn bestudeerd, welke zijn waarschijnlijk thermo-elektrisch' .

Materiële databases zijn de noodzaak van het uur

Je zou aannemen dat we deze lijst al hebben - duidelijk heeft iemand notities gemaakt van al het werk dat we hebben gedaan? Materiaalhandboeken en elektronische databases samenstellen?

Het antwoord is een verrassend nee. De enorme hoeveelheid kennis die we in de loop der jaren hebben vergaard, zit opgesloten in teksten als boeken, tijdschriften en kranten. Er zijn er zoveel dat het voor ons onmogelijk is om ze handmatig te doorzoeken.

Dit is precies waarom het insluiten van woorden en de technieken die in dit artikel worden gedemonstreerd, ronduit revolutionair zijn.

Ze beloven de manier waarop we met tekst omgaan te veranderen en onze database met materialen snel te versnellen.

Wat zijn enkele van de materialen die zijn onderzocht voor piëzo-elektriciteit? Is er een supergeleider die we in de literatuur hebben gemist? Is er een nieuw medicijn dat de ziekte van Alzheimer kan genezen?

Vraag het woord inbeddingen. Ze zouden het weten.

Industriële technologie

- Niet slecht zijn in het aanleren van nieuwe software

- Python New Line:afdrukken ZONDER nieuwe regel in Python

- Hoe een nieuwe lease-accountingstandaard van invloed zal zijn op transport en logistiek

- Hoe de levensmiddelenindustrie reageert op nieuw consumentengedrag

- Hoe een Nieuw-Zeelandse vleesexporteur door de pandemie navigeert

- Succes in een nieuw tijdperk voor grensoverschrijdende e-commerce

- Hoe retailers de impact van nieuwe verzendkosten kunnen verminderen

- Hoe u nieuwe klanten op de markt brengt wanneer bestellingen traag zijn

- Pennsylvania biedt nieuwe financiering om studenten uit Philadelphia te helpen kansen in productie te ontdekken

- Hoe de MTConnect-standaard een nieuw tijdperk in de productie helpt vormgeven

- Plannen voor en investeren in een nieuw CAD/CAM-systeem