Tools gaan hoger in de waardeketen om het mysterie uit visie AI te halen

De voordelen van het toevoegen van visie aan alledaagse producten hebben de aandacht getrokken van vele industrieën en sectoren. Maar hoe haal je daadwerkelijk gegevens van een camera, sluit je machine learning in op het apparaat om het inferentie-algoritme uit te voeren en zorg je ervoor dat iets nuttigs kan worden verwerkt?

Het antwoord, zoals bij elk systeemontwerp, is het hebben van de juiste software, tools, bibliotheken, compilers, enzovoort. Het is geen verrassing dat dergelijke mogelijkheden over het algemeen buiten het bereik van niet-ingenieurs liggen. Maar zelfs onder ontwikkelaars van embedded systemen wordt aangenomen dat de kennis en vaardigheden die nodig zijn voor het ontwerpen van vision-systemen schaars zijn.

Een van de grote uitdagingen is het gebrek aan kennis van de software en tools die beschikbaar zijn voor het ontwikkelen van embedded vision-systemen, zoals Jeff Bier, oprichter van de Edge AI and Vision Alliance, uitlegde in een briefing met EE Timesahead van de Embedded Vision Summit 2021 . Hoewel er aanzienlijke investeringen en onderzoek zijn gedaan naar de algoritmen en het silicium, zijn de softwaretools die tussen hen bemiddelen - compilers, geoptimaliseerde functiebibliotheken, enzovoort - enigszins verwaarloosd, zei Bier.

Het gebruik van de juiste softwaretools, compilers en bibliotheken kan een zeer efficiënte implementatie van een algoritme voor een bepaalde microcontroller of processor opleveren. Maar "in de afgelopen 30 jaar hebben halfgeleiderbedrijven doorgaans te weinig geïnvesteerd in softwaretools", zegt Bier, een veteraan in de embedded systems-industrie en signaalverwerking in het bijzonder. "[Software] wordt vaak gezien als een noodzakelijk kwaad - het is een kostenpost in een zeer kostengevoelig bedrijf - en dat is te zien. Als ontwikkelaar van embedded software kijk je misschien naar de tools die [voor jou] beschikbaar zijn in vergelijking met wat pc- of cloudontwikkelaars hebben en voel je je het onbeminde stiefkind.”

Hij bracht dit argument naar een hoger niveau en voegde eraan toe:"Je hebt misschien expertise op het gebied van embedded systemen, maar de kans bestaat dat deze ontwikkelaars nog nooit met beeldgegevens of diepe neurale netwerken hebben gewerkt."

Vaardigheden zijn een grote uitdaging, zegt Bier. "We hebben misschien wat spreadsheetberekeningen gedaan en gezegd:'Ja, het is mogelijk om dit soort diep neuraal netwerk met voldoende prestaties in onze applicatie te laten werken.' Maar weten we hoe we dat moeten doen? Hebben we de vaardigheden? Voor de meeste organisaties is het antwoord nee, omdat ze in het verleden niet de mogelijkheid hebben gehad om deze technologie te gebruiken. Omdat het een relatief nieuwe technologie is in de commerciële wereld, hebben ze niet de expertise. Ze hebben geen machine learning-afdeling of computer vision-afdeling in hun bedrijf.

"In de afgelopen paar jaar is dit een heel groot knelpunt geworden met betrekking tot commerciële toepassing van computervisie en diepe neurale netwerken - alleen de knowhow."

De technologie wordt echter steeds toegankelijker, omdat bedrijven de afgelopen jaren hebben geprobeerd de vaardigheidskloof te dichten. "De kennis- en vaardigheidskloof was behoorlijk groot, maar wordt kleiner", zei Bier, eraan toevoegend dat "een paar bedrijven", een grote en een kleine, "de leiding op dit gebied hebben genomen." Het grote bedrijf is Intel; de kleine is Edge Impulse.

"Intel heeft vaak indruk op me gemaakt omdat ik tegen de trend inging en op een aantal manieren grote investeringen wilde doen in softwaretools", aldus Bier. “Ze hebben bijvoorbeeld de OpenVINO-toolketen voor edge-computervisie en -inferentie, en DevCloud voor de Edge. Edge Impulse is ook een cloudgebaseerde omgeving. Voor een embedded ontwikkelaar voelt dat [de cloudomgeving] raar aan. Alles voor hen ligt vaak op hun bureau - het ontwikkelbord, het werkstation, de tools - en ze hebben niet eens een internetverbinding nodig. Alles is heel lokaal. Het voelt dus heel vreemd om te zeggen:'Zet je code in de cloud' en voer de tools in de cloud uit."

De trend richt zich zowel op de tijd tot implementatie als op de vaardigheidskloof. Een veel voorkomende frustratie voor embedded ontwikkelaars is om toegang te krijgen tot boards en tools en ze correct te installeren, zei Bier. De tijdlijn wordt "meestal gemeten in weken, soms in maanden, en dat is pijnlijk, vooral als je je aan het einde realiseert dat dit niet is wat je nodig had en je het proces met een aantal andere borden moet herhalen." U kunt bijvoorbeeld aan het einde van het proces ontdekken dat "u de volgende nodig heeft, met hogere prestaties of een andere set I/O-interfaces."

Maar als de leverancier "alle ontwikkelborden in de cloud op hun machines heeft aangesloten en er naar believen toegang toe heeft, biedt enorm veel gemak. Evenzo hebben ze de nieuwste versies van de softwaretools en hebben ze alle onderlinge afhankelijkheden opgelost.”

De weg vrijmaken voor het implementeren van visie

Dus hoe versnelt u de implementatie van embedded vision om functies zoals objectdetectie en -analyse mogelijk te maken, of het nu gaat om slimme steden, fabrieken, winkels of andere toepassingen?

Bedrijven die de door Bier beschreven pijnpunten hebben gerealiseerd, pakken ze aan. Sommige bieden nu tools zoals cloudgebaseerde ontwikkelingssystemen waarmee u uw code of gegevens kunt invoeren en in een mum van tijd evaluaties kunt krijgen. Anderen bieden referentieontwerpen waarmee u eenvoudig uw camera-uitgang kunt aansluiten en kunt kiezen uit bibliotheken of apps die inferentie-algoritmen voor veelvoorkomende toepassingen bieden.

In het voormalige kamp bieden Intel DevCloud for the Edge en Edge Impulse cloudgebaseerde platforms die de meeste pijnpunten wegnemen met gemakkelijke toegang tot de nieuwste tools en software. In het laatste zijn Xilinx en anderen begonnen met het aanbieden van complete systemen-op-module met productieklare applicaties die kunnen worden ingezet met tools op een hoger abstractieniveau, waardoor enkele van de meer specialistische vaardigheden overbodig zijn.

Prototype, benchmark en test AI-inferentie in de cloud

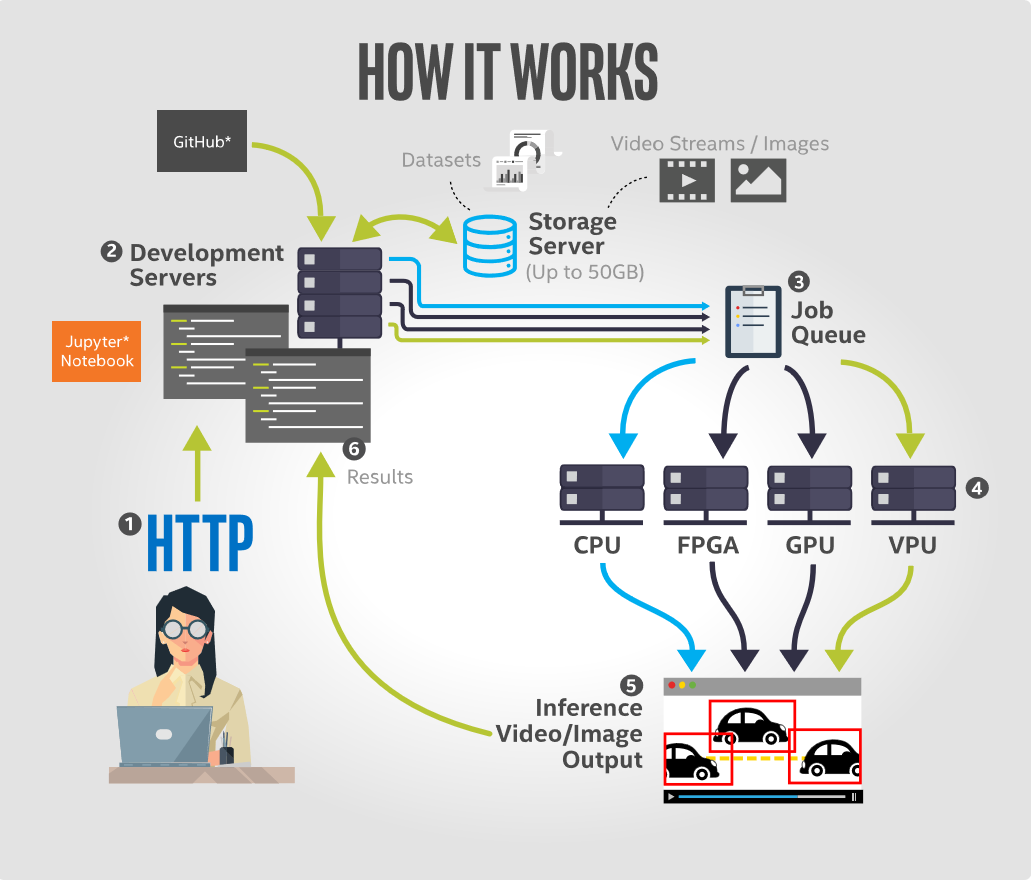

Met Intel DevCloud for the Edge kunnen gebruikers AI-inferentietoepassingen ontwikkelen, prototypen, benchmarken en testen op een reeks Intel-hardware, waaronder CPU's, geïntegreerde GPU's, FPGA's en vision-verwerkingseenheden (VPU's). Met zijn Jupyter Notebook-interface bevat het platform tutorials en voorbeelden die vooraf zijn geladen met alles wat nodig is om snel aan de slag te gaan. Dit omvat vooraf getrainde modellen, voorbeeldgegevens en uitvoerbare code van de nieuwste versie van de Intel-distributie van OpenVINO-toolkit, evenals andere tools voor diepgaand leren. Alle ondersteunende apparaten zijn geconfigureerd voor optimale prestaties en klaar voor uitvoering van gevolgtrekkingen.

Het belangrijkste voordeel voor de ontwikkelaar is dat het platform geen hardware-installatie vereist aan de gebruikerskant. De browsergebaseerde ontwikkelomgeving van Jupyter Notebook stelt ontwikkelaars in staat om code vanuit hun browser uit te voeren en de resultaten direct te visualiseren. Hierdoor kunnen ze prototypes van computervisie-oplossingen maken in de cloudomgeving van Intel en zien hoe hun code wordt uitgevoerd op elke combinatie van de beschikbare hardwarebronnen.

Dit cloudgebaseerde aanbod heeft drie belangrijke voordelen. Ten eerste wordt het probleem van de verlamming van de hardwarekeuze aangepakt. Ontwikkelaars kunnen AI-applicaties op afstand uitvoeren op een breed scala aan hardware om te bepalen welke het beste is voor hun oplossing op basis van factoren zoals uitvoeringstijd voor gevolgtrekkingen, stroomverbruik en kosten.

Ten tweede biedt het directe externe toegang tot de nieuwste Intel edge-hardware. Wat de software betreft, lost het het probleem op van het omgaan met verouderde software, omdat het directe toegang biedt tot de nieuwste versie van Intel Distribution van OpenVINO-toolkit en compatibele edge-hardware.

En ten derde biedt het toegang tot applicatiespecifieke prestatiebenchmarks in een gemakkelijk te vergelijken, zij-aan-zij-indeling.

(Een zelfstudie over het uitvoeren van objectdetectiemodellen met Intel DevCloud for the Edge is hier beschikbaar.)

Bouw een model in de cloud, kijk wat er live gebeurt

Een andere benadering is om gegevens in een cloudplatform in te voeren om trainingsmodellen te visualiseren en te maken en deze op embedded apparaten te implementeren. Edge Impulse doet precies dat en biedt een cloudgebaseerde ontwikkelomgeving die het eenvoudig maakt om machine learning toe te voegen aan edge-apparaten zonder dat een Ph.D. in machine learning, volgens het bedrijf.

Het platform stelt gebruikers in staat om uit het veld verzamelde beeldgegevens te importeren, snel classificaties te bouwen om die gegevens te interpreteren en modellen terug te zetten naar productie-apparaten met een laag energieverbruik. Een sleutel tot het Edge Impulse-webplatform is de mogelijkheid om alle verkregen gegevens te bekijken en te labelen, voorverwerkingsblokken te maken om gegevens aan te vullen en te transformeren, de afbeeldingsgegevensset te visualiseren en modellen op trainingsgegevens rechtstreeks vanuit de gebruikersinterface te classificeren en valideren.

Omdat het best moeilijk kan zijn om vanaf het begin een computervisiemodel te bouwen, gebruikt Edge Impulse een proces van transfer learning om het gemakkelijker en sneller te maken om modellen te trainen. Dit omvat meeliften op een goed getraind model en alleen de bovenste lagen van een neuraal netwerk omscholen, wat leidt tot veel betrouwbaardere modellen die in een fractie van de tijd trainen en met aanzienlijk kleinere datasets werken. Met het model ontworpen, getraind en geverifieerd, is het vervolgens mogelijk om dit model terug te implementeren op het apparaat. Het model kan dan zonder internetverbinding op het apparaat draaien, met alle inherente voordelen van dien, zoals het minimaliseren van latentie, en draait met een minimaal stroomverbruik. Het complete model is verpakt met voorbewerkingsstappen, neurale netwerkgewichten en classificatiecode in een enkele C++-bibliotheek die kan worden opgenomen in de embedded software.

Naar een hoger abstractieniveau gaan

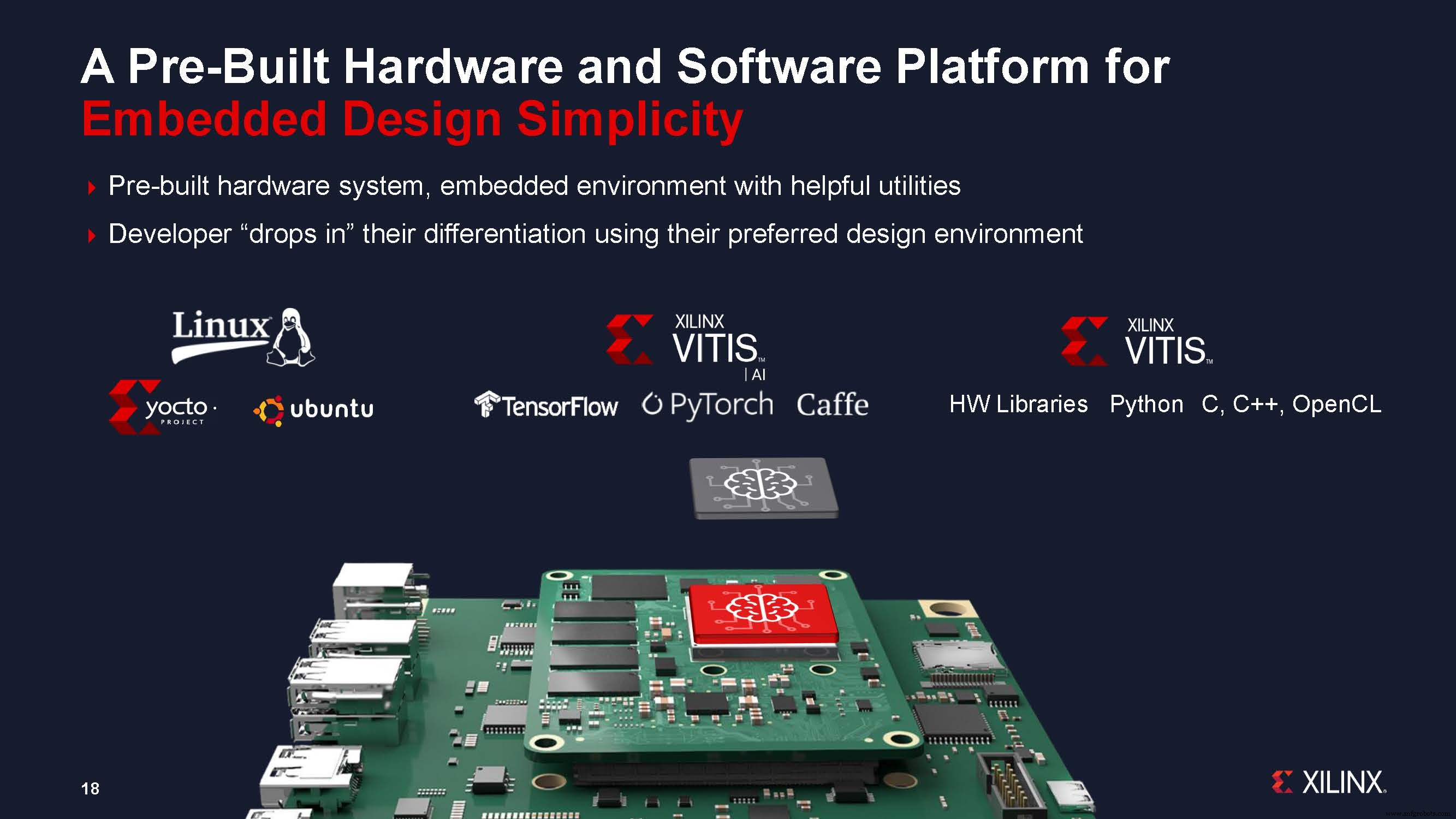

Een andere benadering die door leveranciers wordt aangeboden, is om de ontwikkelingstijd te verkorten door op modules gebaseerde systemen aan te bieden en ontwerp op een hoger abstractieniveau mogelijk te maken. Xilinx zei dat zijn nieuwe systems-on-module (SOM's)-benadering de ontwikkelingstijd voor vision-systemen tot negen maanden kan verkorten, door de toenemende complexiteit in vision-AI aan te pakken en de uitdagingen voor het implementeren van AI aan de rand aan te pakken.

Xilinx heeft onlangs het eerste product aangekondigd in zijn nieuwe portfolio van SOM's:de Kria K26 SOM, specifiek gericht op vision AI-toepassingen in slimme steden en slimme fabrieken, samen met een kant-en-klare, goedkope ontwikkelkit, de Kria KV260 AI vision-startpakket.

Chetan Khona, directeur industrie, visie en gezondheidszorg bij Xilinx, zei tijdens de persconferentie om de nieuwe modulefamilie te lanceren:"Productieklare systemen zijn belangrijk voor snelle implementatie [van embedded vision AI]. Klanten kunnen tot negen maanden ontwikkelingstijd besparen door een modulegebaseerd ontwerp te gebruiken in plaats van een apparaatgebaseerd ontwerp.” Hij voegde eraan toe dat gebruikers met de starterkit binnen een uur aan de slag kunnen, "zonder dat FPGA-ervaring nodig is." Gebruikers sluiten de camera, kabels en monitor aan, plaatsen de geprogrammeerde microSD-kaart en zetten het bord aan, en kunnen vervolgens een versnelde toepassing van hun keuze selecteren en uitvoeren.

Het Kria SOM-portfolio koppelt het hardware- en softwareplatform aan productieklare vision-versnelde applicaties. Deze kant-en-klare toepassingen elimineren al het FPGA-hardwareontwerpwerk; softwareontwikkelaars hoeven alleen hun aangepaste AI-modellen en applicatiecode te integreren en optioneel de vision-pipeline aan te passen - met behulp van bekende ontwerpomgevingen, zoals TensorFlow, Pytorch of Café-frameworks, evenals C-, C++-, OpenCL- en Python-programmeertalen.

De Kria SOM's maken ook aanpassing en optimalisatie mogelijk voor embedded ontwikkelaars met ondersteuning voor standaard Yocto-gebaseerde PetaLinux. Xilinx zei dat er ook een samenwerking met Canonical aan de gang is om Ubuntu Linux-ondersteuning te bieden, de zeer populaire Linux-distributie die wordt gebruikt door AI-ontwikkelaars. Dit biedt brede bekendheid met AI-ontwikkelaars en interoperabiliteit met bestaande applicaties. Klanten kunnen zich in beide omgevingen ontwikkelen en beide benaderingen van productie volgen. Beide omgevingen zijn vooraf gebouwd met een software-infrastructuur en handige hulpprogramma's.

We hebben drie benaderingen uitgelicht die leveranciers volgen om de vaardigheids- en kenniskloof aan te pakken, evenals de implementatietijd, voor de ontwikkeling van embedded vision-systemen. De cloudgebaseerde benaderingen bieden tools die de mogelijkheid "democratiseren" om modellen te maken en te trainen en hardware te evalueren voor extreem snelle implementatie op embedded apparaten. En de aanpak die een module of referentieontwerp met een app-bibliotheek biedt, stelt AI-ontwikkelaars in staat om bestaande tools te gebruiken om snel embedded vision-systemen te creëren. Deze zorgen er allemaal voor dat we op een andere manier naar ontwikkelborden en -tools kijken. Ze halen het mysterie uit de ingebedde visie door hoger in de waardeketen te komen, en het fundamentele werk over te laten aan de tools en modules van de leveranciers.

Verwante inhoud :

- Ingebouwde visie op het kantelpunt

- Vijf trends om in de gaten te houden in Embedded Vision en Edge AI

- Zullen machines ooit volledig begrijpen wat ze zien?

- Xilinx SOM richt zich op een bredere acceptatie van edge AI en embedded vision

- Embedded Vision Summit:ML-perceptie op kleine FPGA's

- GWM gebruikt Ambarella AI vision SoC voor nieuwe SUV

- AImotive toont 98% edge vision-efficiëntie op Nextchip Apache5

- Low power AI vision board gaat 'jaren' mee op één batterij

- OmniVision verkleint medische beeldsensor voor diepere endoscopie

Ingebed

- Machinevisie-inspectie:tools van het vak

- AI-toepassingen in de wereldwijde toeleveringsketen

- Haal het giswerk uit onderhoudsbeslissingen

- Drew Troyer:de waardeketen van apparatuur, deel 3

- Drew Troyer:de waardeketen van apparatuur, deel 2

- Drew Troyer:de waardeketen van apparatuur, deel 1

- Zal 5G de visie van 2020 waarmaken?

- De waarde van IoT-gegevens maximaliseren

- De waarde van analoge meting

- Het potentieel van AI in de supply chain voor de gezondheidszorg

- De supply chain herdenken als een waardeaanjager