De geschiedenis van AI:van futuristische fictie tot de toekomst van ondernemingen

Zeg de woorden 'kunstmatige intelligentie' en de meeste mensen denken aan Alexa en Siri. Anderen denken misschien aan films als The Terminator of 2001:A Space Odyssey.

De waarheid is dat kunstmatige intelligentie (AI) geen ver verwijderd sciencefictionconcept is. Het is eigenlijk overal om ons heen, denk aan Netflix die je volgende tv-programma aanbeveelt of Uber die de beste route naar huis optimaliseert.

AI is een geavanceerd ecosysteem van moderne, onderling verbonden technologieën die in de loop van tientallen jaren zijn geëvolueerd - en vandaag de dag nog steeds evolueren. Het hoeft dan ook niet te verbazen dat de geschiedenis van AI ook complex en gelaagd is. Het is een geschiedenis met een verscheidenheid aan veranderende tools en mogelijkheden die de AI zoals we die nu kennen, hebben opgebouwd tot zijn huidige staat.

Om het belang van AI vandaag te begrijpen - en om je voor te bereiden op morgen - helpt het om te begrijpen waar AI begon en hoe het zich heeft ontwikkeld tot de baanbrekende technologie die het vandaag is.

20e-eeuwse AI:een ambitieus proof of concept

Moderne AI werd geboren in de academische kamers van elite universitaire onderzoeksafdelingen, waar wetenschappers diep nadachten over de toekomst van computers. Maar in de beginjaren bleef het beperkt tot deze kamers, gestrand dankzij een gebrek aan gegevens en rekenkracht.

In 1956 organiseerde Dartmouth College het Dartmouth Summer Research Project on Artificial Intelligence - een workshop die bekend werd als een cruciale eerste stap in het academisch onderzoek naar AI. Tijdens de workshop probeerden 20 onderzoekers de hypothese te bewijzen dat leren zo precies kan worden beschreven "dat er een machine kan worden gemaakt om het te simuleren".

Een jaar later, in 1957, breidde de Amerikaanse psycholoog Frank Rosenblatt het Dartmouth-onderzoek uit met perceptron, een algoritme dat met succes binaire classificatie kon uitvoeren. Dit was waar we veelbelovend bewijs begonnen te zien van hoe kunstmatige neuronen van gegevens konden leren.

En nog een jaar later ontwikkelden John McCarthy, een deelnemer aan het Dartmouth Summer Research Project on Artificial Intelligence, en tal van studenten van MIT, Lisp (een nieuwe programmeertaal). Decennia later zou het onderzoek van McCarthy helpen om nieuwe en nog opwindendere projecten tot leven te brengen, waaronder het natuurlijke taalprogramma SHRDLU, het Macsyma-algebrasysteem en het ACL2-logicasysteem.

Bron

Als we terugkijken op deze vroege experimenten, zien we dat AI zijn eerste, wankele stappen zet van de wereld van hoogstaand onderzoek naar de praktische wereld van computers.

Het jaar 1960 zag het debuut van Simulmatics, een bedrijf dat beweerde te kunnen voorspellen hoe mensen zouden stemmen op basis van hun demografie.

In 1965 ontwikkelden onderzoekers zogenaamde 'expertsystemen'. Met deze systemen kon AI gespecialiseerde problemen binnen computersystemen oplossen door een verzameling feiten en een inferentie-engine te combineren om gegevens te interpreteren en te evalueren.

Een jaar later, in 1966, ontwierp MIT-professor Joseph Weizenbaum een programma voor het matchen van patronen, Eliza genaamd, dat gebruikers liet zien dat AI intelligent was. Gebruikers konden informatie aan het programma geven en Eliza, optredend als psychotherapeut, zou hen als antwoord een open vraag geven.

Halverwege de jaren zeventig begonnen overheden en bedrijven het vertrouwen in AI te verliezen. De financiering droogde op en de periode die volgde werd bekend als de 'AI-winter'. Hoewel er in de jaren tachtig en negentig kleine oplevingen waren, werd AI meestal verbannen naar het rijk van sciencefiction en werd de term vermeden door serieuze computerwetenschappers.

Aan het eind van de jaren negentig tot het begin van de jaren 2000 zagen we grootschalige toepassing van machine learning-technieken zoals Bayesiaanse methoden voor spamfiltering door Microsoft en collaboratieve filtering voor Amazon-aanbevelingen.

21e-eeuwse AI:enorm succesvolle proefprogramma's

In de jaren 2000 stelden rekenkracht, grotere datasets en de opkomst van open-sourcesoftware ontwikkelaars in staat om geavanceerde algoritmen te creëren die in relatief korte tijd een revolutie teweeg zouden brengen in de wetenschappelijke, consumenten-, productie- en zakengemeenschappen. AI is tegenwoordig voor veel bedrijven een realiteit geworden. McKinsey heeft bijvoorbeeld 400 voorbeelden gevonden waar bedrijven momenteel AI gebruiken om zakelijke problemen aan te pakken.

Het web biedt nieuwe manieren om gegevens te ordenen

De webrevolutie die de wereld overspoelde in het begin tot het midden van de jaren 2000, zorgde voor enkele belangrijke veranderingen in de wereld van AI-onderzoek. Fundamentele technologieën zoals Extensible Markup Language (XML) en PageRank organiseerden gegevens op nieuwe manieren die AI zou kunnen gebruiken.

XML was een voorwaarde voor het semantische web en voor zoekmachines. PageRank, een vroege innovatie van Google, organiseerde het web verder. Deze verbeteringen maakten het web bruikbaarder en maakten grote hoeveelheden gegevens toegankelijker voor AI.

Tegelijkertijd werden databases steeds beter in het opslaan en ophalen van gegevens, terwijl ontwikkelaars werkten aan functionele programmeertalen die het gemakkelijker maakten om die gegevens te gebruiken. De tools waren aanwezig voor onderzoekers en ontwikkelaars om AI-technologie verder te ontwikkelen.

Neurale netwerken en deep learning demonstreren het potentieel van AI

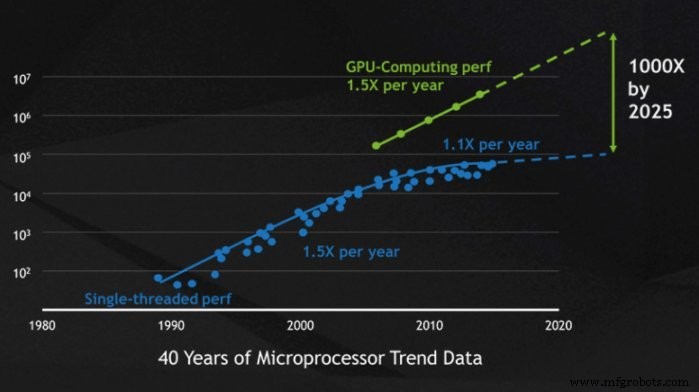

Er waren grote dromen voor AI in de 20e eeuw, maar rekenkracht maakte het bijna onmogelijk om ze te bouwen. Tegen de 21e eeuw werden computers echter exponentieel krachtiger in het opslaan, verwerken en analyseren van grote hoeveelheden gegevens. Dit betekende dat de hoge doelen van neurale netwerken en deep learning werkelijkheid konden worden.

Onderzoekers ontwikkelden datasets die specifiek geschikt waren voor het trainen van machines, wat resulteerde in neurale netwerken zoals AlexNet. Voorheen was machinetraining afhankelijk van datasets die in de tienduizenden liepen, maar de opmars van grafische verwerkingseenheden (GPU's) betekende dat nieuwe datasets in de tientallen miljoenen konden lopen.

Computerchipfabrikant Nvidia lanceerde in 2006 hun parallel computerplatform, CUDA. Binnen dit platform gebruikte Nvidia GPU's om hun computer sneller te maken. Deze prestatieverbetering hielp meer mensen om grote en complexe machine learning-modellen te gebruiken die zijn geschreven in machine learning-bibliotheken zoals TensorFlow en PyTorch.

Bron

Later zouden deze bibliotheken open source worden en wijdverbreide experimenten inspireren naarmate de technologie toegankelijker werd. Deze democratisering van AI zou opwindende nieuwe tools zoals AlphaGo, Google DeepMind en IBM Deep Blue van de grond helpen.

Computervisie opent de deur naar nieuwe industriële toepassingen

Tot de jaren 2000 was AI alleen echt nuttig als je tekst aan het verwerken was. Maar rond de eeuwwisseling dreven de ontwikkelingen in computervisie, waardoor computers afbeeldingen konden herkennen en interpreteren, de use-cases van AI naar nieuwe hoogten.

Deze keer waren onze pioniers geen academici. In plaats daarvan woonden ze in je huis en maakten schoonmaken (de Roomba) en gamen (de XBox Kinect) gemakkelijker dan ooit tevoren en brachten computervisie in huizen over de hele wereld.

We zagen ook dat computervisie werd gebruikt in opkomende zelfrijdende auto's en in ziekenhuizen om automatisch aandoeningen zoals laesies en longontsteking te detecteren.

Naast branchespecifieke gebruiksscenario's, heeft de variatie in computervisie ook bijgedragen aan de ontwikkeling van robotprocesautomatisering (RPA). 🎉 Aangevuld met optische tekenherkenning (OCR), kunnen RPA-robots zowel gestructureerde als ongestructureerde gegevens verwerken, wat de wereld van gegevensanalyse zoals we die kennen heeft veranderd.

Gegevensanalyse verbetert AI-bedrijfsapplicaties

De afgelopen twee decennia hebben ons laten zien dat automatisering en AI zich kunnen meten met complexe zakelijke use-cases. En naarmate AI nog beter wordt in het analyseren van gegevens, kunnen bedrijven AI nog meer gebruiken om hen te helpen slimmer en efficiënter te werken.

Banken gebruiken AI om vragen van klanten in verschillende categorieën in te delen, van grote hoeveelheden ongestructureerde e-mails die jaarlijks worden ontvangen. Dit proces is handmatig intensief of levert slechte resultaten op bij gebruik van op regels gebaseerde trefwoordclassificatie. AI stelt banken in staat om deze e-mails zeer nauwkeurig te classificeren en de gemiddelde verwerkingstijd (AHT) te verminderen.

AI en automatisering helpen niet alleen financiële dienstverleners. Zorgbetalers versnellen de identificatie van risicozwangerschappen. De softwarerobot laadt geverifieerde patiëntgegevens en heeft toegang tot een voorspellend model om de patiënt te beoordelen op risico's en bepaalt het juiste zorgbeheerplan. De resultaten zijn dat het aantal zwangerschappen met een laag geboortegewicht dat nauwkeurig werd geïdentificeerd met 24% toenam, terwijl 44% van de zwangerschappen met een laag geboortegewicht werd vermeden, wat in totaal $ 11 miljoen per jaar bespaart. Lees het volledige verhaal.

Natuurlijke taalverwerking en spraakherkenning vergroten de bruikbaarheid van AI

Hoewel AI is begonnen met de analyse van tekst, heeft het deze nog lang niet onder de knie. Tot voor kort moest tekst, zelfs met OCR, worden gestructureerd in machineleesbare formaten. Het gebied van natuurlijke taalverwerking (NLP) heeft het voortouw genomen in de mogelijkheid om computers te programmeren om natuurlijke taal te begrijpen.

Een van de bekendere voorbeelden van NLP is Generative Pre-trained Transformer 3 (beter bekend als GPT-3). GPT-3, geïntroduceerd in mei 2020, maakt gebruik van deep learning om tekst te genereren die sterk lijkt op door mensen gemaakte tekst. Er zijn al interessante toepassingen voor GPT-3 ontstaan, zoals het schrijven van artikelen (The Guardian bijvoorbeeld gaf GPT-3 de opdracht een artikel te schrijven over de onschadelijkheid van robots) en het genereren van computerprogramma's.

De toepassingen van NLP gaan verder dan GPT-3. NLP kan worden gebruikt om tekst uit spraak te maken, automatisch de betekenis van een stuk tekst samen te vatten, tekst in verschillende talen te vertalen en meer.

Hoewel NLP vaak op het scherpst van de snede bestaat, heeft het ook zijn weg gevonden naar onze huizen. Virtuele assistenten zoals Alexa en Google kunnen bijvoorbeeld natuurlijke taalverzoeken verwerken en vertalen naar uitvoerbare opdrachten. Met een eenvoudig spraakverzoek kunnen deze AI-assistenten naar informatie zoeken; routeopdrachten naar slimme apparaten, zoals lichten of sloten; en meer.

De toekomst van AI:een zakelijke game-changer

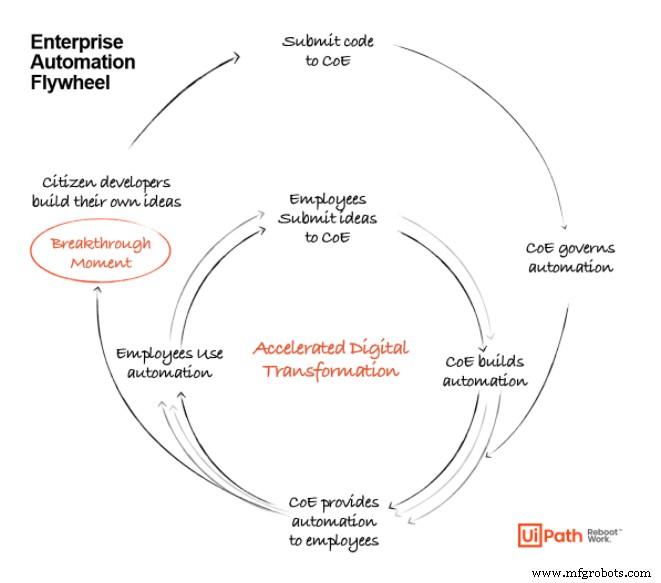

Nu we het volgende decennium van technologische volwassenheid ingaan, zullen de zakelijke use-cases voor AI alleen maar blijven groeien. Eerdere tools hebben de basis gelegd voor wat mogelijk is met AI, maar er valt nog veel te winnen door deze tools op schaal te brengen.

Naarmate AI nog verder evolueert, zullen bedrijven RPA, machine learning, process mining en data-analyse gebruiken om een krachtige, end-to-end suite van automatisering te creëren, aangezien deze technologieën steeds toegankelijker worden voor bedrijven in alle volwassenheidsstadia. . AI zal niet langer het exclusieve domein zijn van onderzoekers en ontwikkelaars; alledaagse gebruikers, geholpen door moderne tools, zullen in staat zijn om AI-gebaseerde oplossingen te creëren voor de problemen die ze identificeren.

Naarmate de technologie toegankelijker wordt voor zakelijke gebruikers, zullen we het vliegwiel van automatisering zien draaien om bedrijven te voorzien van steeds meer ideeën en mogelijkheden voor AI-toepassingen. Deze mogelijkheden worden ondersteund door geavanceerde automatiseringsplatforms en tools die onze manier van werken opnieuw zullen opstarten en een revolutie teweeg zullen brengen.

UiPath AI Fabric maakt het gebruikers gemakkelijk om een model te lanceren, er gegevens in te pompen, inzichten te verkrijgen en het nut te beoordelen.

Noot van de redactie: Naarmate de automatiseringsmarkt blijft evolueren, wordt het UiPath-platform ook bijgewerkt om zo goed mogelijk te voldoen aan de automatiseringsbehoeften van onze klanten. Als zodanig is de productnaam van AI Fabric geëvolueerd sinds het artikel oorspronkelijk werd gepubliceerd. Voor actuele informatie, gelieve bezoek onze AI Center-pagina .

AI vandaag:het juiste moment om te beginnen

Het is tijd om te automatiseren. We hebben het stadium in AI-evolutie bereikt waar het niet theoretisch is - het is absoluut noodzakelijk en zal naar verwachting honderden miljarden dollars aan waarde vrijmaken voor bedrijven die het omarmen.

Ontdek hoe toonaangevende organisaties automatisering en AI gebruiken om de visie van een volledig geautomatiseerde onderneming™ te realiseren:

Automatisering Besturingssysteem

- De toekomst voor contactloze bezorging

- De geschiedenis en toekomst van aluminium extrusie

- Boston Dynamics &Trimble:The Future of Construction

- Fabrieken van de toekomst:industriële productie 1.0 tot 4.0

- Nokia's 'bewuste' fabriek van de toekomst

- De toekomst van onderhoudstechniek

- Automatisering en de toekomst van digitale productie?

- De oorsprong van het zaagconcept:geschiedenis en toekomst

- Wat te verwachten van CNC-frezen in de toekomst?

- Welkom in de toekomst van 3D-zicht

- Cobots versus robots – de toekomst van productie