Voldoe aan de ETL-uitdagingen van IoT-gegevens en maximaliseer de ROI

Organisaties kunnen IoT-gegevens optimaliseren en snel en kosteneffectief hun bedrijfswaarde ontlenen door expertise te ontwikkelen in ETL-technologieën (extract, transfer, load).

Het potentieel van IoT is nog nooit zo groot geweest. Met investeringen in IoT-compatibele apparaten die naar verwachting in 2021 zullen verdubbelen en de kansen toenemen in de data- en analysesegmenten, is de belangrijkste taak het overwinnen van de uitdagingen en het temmen van de kosten rondom IoT-gegevensprojecten.

Organisaties kunnen IoT-gegevens optimaliseren en snel en kosteneffectief hun bedrijfswaarde ontlenen door expertise te ontwikkelen in ETL-technologieën (extract, transfer, load), zoals streamverwerking en datalakes.

Zie ook: 4 principes om een ongerept datameer mogelijk te maken

Bij veel organisaties kan dit echter leiden tot IT-knelpunten, lange projectvertragingen en uitstel van datawetenschap. Resultaat:IoT-projecten – waarin voorspellende analysegegevens een cruciale rol moeten spelen bij het verbeteren van de operationele efficiëntie en het stimuleren van innovatie – nog steeds hebben de proof-of-concept-drempel niet overschreden en kunnen absoluut geen ROI aantonen.

Begrijp de ETL-uitdagingen waarmee IoT wordt geconfronteerd

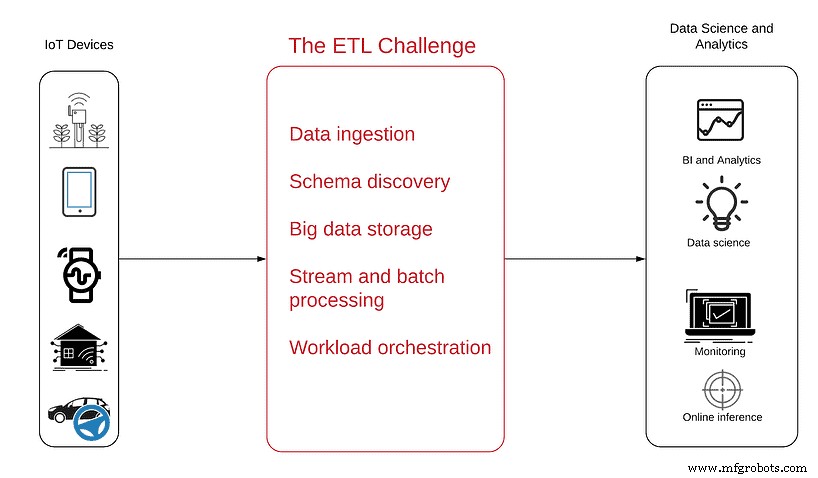

Het volgende diagram helpt u het probleem beter te begrijpen:

De gegevensbron bevindt zich aan de linkerkant - ontelbare met sensoren gevulde apparaten, van eenvoudige antennes tot gecompliceerde autonome voertuigen die IoT-gegevens genereren en deze als een ononderbroken stroom van semi-gestructureerde gegevens via internet verzenden.

Aan de rechterkant staan de doelen die het verbruik van de gegevens moet bereiken, met de resulterende analytische producten aan het einde van het project, waaronder:

- Bedrijfsinformatie om inzicht te krijgen in trends en patronen in productgebruik

- Operationele monitoring om storingen en inactieve apparaten in realtime te zien

- Anomaliedetectie om proactieve waarschuwingen te krijgen over pieken of steile dalingen in de gegevens

- Ingesloten analyse om klanten in staat te stellen hun eigen gebruiksgegevens te zien en te begrijpen

- Gegevenswetenschap om te profiteren van de voordelen van geavanceerde analyses en machine learning bij voorspellend onderhoud, routeoptimalisatie of AI-ontwikkeling

Om deze doelen te bereiken, moet u eerst gegevens transformeren van de onbewerkte streamingmodus naar analyseklare tabellen die kunnen worden opgevraagd met SQL en andere analysetools.

Het ETL-proces is vaak het moeilijkst te begrijpen segment van elk analyseproject, omdat IoT-gegevens een unieke reeks eigenschappen bevatten die niet altijd synchroon lopen met de gebruikelijke relationele databases, ETL en BI-tools. Bijvoorbeeld:

- IoT-gegevens streamen gegevens, voortdurend gegenereerd in kleine bestanden die zich ophopen tot enorme, uitgestrekte datasets. Deze zijn heel anders dan traditionele tabelgegevens en vereisen complexere ETL om samenvoegingen, aggregaties en gegevensverrijking uit te voeren.

- IoT-gegevens moeten nu worden opgeslagen en later worden geanalyseerd. In tegenstelling tot typische datasets, betekent de enorme hoeveelheid gegevens die door IoT-apparaten wordt gecreëerd, dat het een zitplaats moet hebben voordat het kan worden geanalyseerd:een datameer in de cloud of op locatie.

- IoT-gegevens presenteren ongeordende gebeurtenissen vanwege meerdere apparaten die zich in en uit gebieden met internetconnectiviteit kunnen verplaatsen. Dit betekent dat logbestanden servers op verschillende tijdstippen kunnen bereiken en niet altijd in de "juiste" volgorde.

- IoT-gegevens vereisen vaak toegang met een lage latentie. Operationeel kan het zijn dat u afwijkingen of specifieke apparaten in realtime of bijna realtime moet identificeren, zodat u zich de vertragingen die worden veroorzaakt door batchverwerking niet kunt veroorloven.

Moet u open-source frameworks gebruiken om een datameer te creëren?

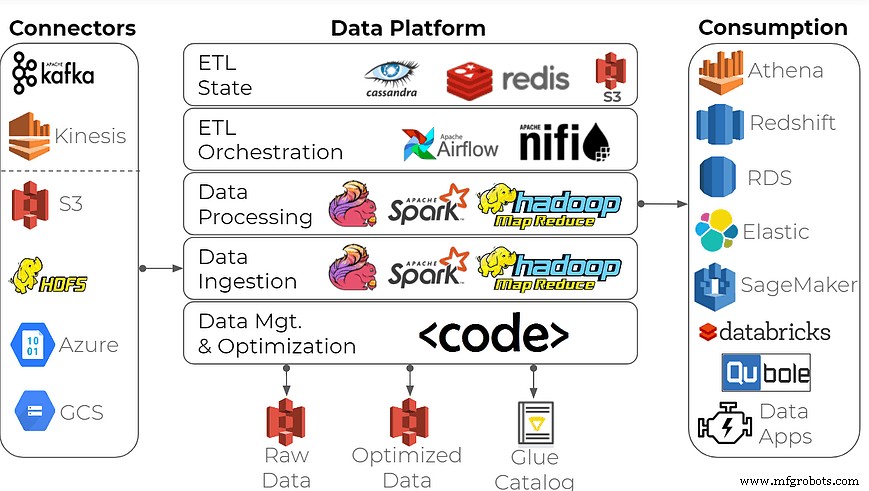

Om een bedrijfsdataplatform voor data-analyse te bouwen, gebruiken veel organisaties deze algemene aanpak:maak een datameer met behulp van open-source streamverwerkingsframeworks als bouwstenen plus tijdreeksdatabases zoals Apache Spark/Hadoop, Apache Flink, InfluxDB en andere.

Kan deze toolset het werk doen? Natuurlijk, maar het correct doen kan overweldigend zijn voor alle bedrijven, behalve voor de meeste data-ervaren bedrijven. Het bouwen van zo'n dataplatform vereist de gespecialiseerde vaardigheden van bigdata-ingenieurs en sterke aandacht voor de data-infrastructuur - meestal niet een sterk punt in productie en consumentenelektronica, industrieën die nauw samenwerken met IoT-gegevens. Verwacht late leveringen, hoge kosten en een hoop verspilde engineering-uren.

Als uw organisatie hoge prestaties wil plus een volledig scala aan functionaliteiten en gebruiksscenario's - operationele rapportage, ad-hocanalyse en gegevensvoorbereiding voor machine learning - kies dan voor een geschikte oplossing. Een voorbeeld zou zijn om een data lake ETL-platform te gebruiken dat speciaal is gebouwd om streams om te zetten in datasets die klaar zijn voor analyse.

De oplossing is niet zo rigide en complex als Spark/Hadoop-dataplatforms. Het is gebouwd met een self-service gebruikersinterface en SQL, niet de intense codering in Java/Scala. Voor analisten, datawetenschappers, productmanagers en dataproviders in DevOps en data-engineering kan het een echt gebruiksvriendelijke tool zijn die:

- Biedt selfservice voor dataconsumenten zonder afhankelijk te zijn van IT en data-engineering

- Optimaliseert ETL-stromen en big data-opslag om infrastructuurkosten te verlagen

- Hiermee kunnen organisaties, dankzij de volledig beheerde service, zich concentreren op functies in plaats van op infrastructuur

- Vernietigt de noodzaak om meerdere systemen te onderhouden voor realtime gegevens, ad-hocanalyses en rapportage

- Zorgt ervoor dat de gegevens nooit het AWS-account van de klant verlaten voor totale veiligheid

U kunt profiteren van IoT-gegevens - er zijn alleen de juiste tools nodig om ze nuttig te maken.

Internet of Things-technologie

- Slimme data:de volgende grens in het IoT

- Eenvoudig, interoperabel en veilig – de IoT-visie realiseren

- IoT-gegevens benutten van de edge naar de cloud en terug

- Welke sectoren zullen de winnaars zijn van de IoT-revolutie en waarom?

- De noodzaak om data te integreren is urgent en niet triviaal, zegt de vader van het IoT

- De drie belangrijkste uitdagingen bij het voorbereiden van IoT-gegevens

- Zijn IoT en cloud computing de toekomst van data?

- AIoT:de krachtige convergentie van AI en het IoT

- Het IoT democratiseren

- De waarde van IoT-gegevens maximaliseren

- IoT en uw begrip van data